斯坦福李飞飞、通院朱松纯两位教授坐镇,还有ucla、微软研究院及xbox团队、清华、北大参与其中。

研究提出多智能体框架mindagent,利用大模型给游戏npc规划和协作的能力。

用在现成游戏中,我的世界里npc“活”了,变成我的ai世界。

也开发了新游戏作为测试基准,玩法类似分手厨房,但你玩得不好ai也不会和你分手。

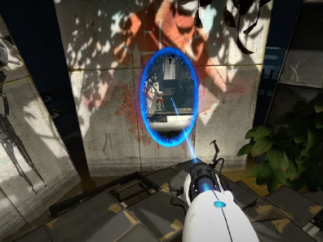

我的ai世界,甚至支持vr

简单来说,mindagent框架给了游戏npc规划复杂任务的能力,以及相互协作、与人类玩家协作。

在我的世界中,首先测试了多智能体协作能力,任务是完成不同类型肉食的烹饪。

可以看到左图中alex和steve分别狩猎不同动物,右图是两个npc狩猎完成后一起在炉子旁煮肉。

人机协作中,人类玩家可以通过语音聊天向npc实时表达自己的意图和期望的目标。

甚至支持vr模式,将玩家与npc的交互体验提升到一个新的水平。

在我的世界测试中,新任务生成间隔(t值)越大、规划难度越小,gpt-4在简单到中等(t3-t5)任务中表现不错,高难任务中表现有明显下降。

cos指标衡量多智能体协作的效率,gpt-4在不同难度任务下平均完成了58%的任务。

分手厨房,没朋友也能玩了

研究还设计了测试基准cuisineworld。

规则类似著名联机游戏《胡闹厨房》,2-4位玩家需要在限制时间内分工配合完成各种菜品的制作并送达顾客手中。

(因为玩家之间配合不好容易“友尽”,在玩家群体中被戏称为分手厨房。)

与我的世界一样,cuisineworld同样支持智能体间协作,人机协作,以及vr交互。

由于专为智能体协作打造,在cuisineworld上可以方便完成更多测试。

这回gpt-4、chatgpt(gpt-3.5-turbo0613)、claude-2和llama2 70b都参与进来。

结果gpt-4只控制两个智能体就能完成68%的任务,claude-2能完成31%,llama2和chatgpt则根本不会玩。

另外3个gpt-4就已经能完成80%的任务,再加到4个效果已经不明显,claude-2增加智能体数量还有进步空间。

mindagent框架,让大模型学会规划

那么大模型到底怎么学会玩游戏的呢?

也就是靠研究中提出的mindagent框架了,主要由提示、当前状态和记忆三个组件组成。

提示组件中包含菜谱、一般说明、推理知识和单样本演示。

当前状态组件提供对环境的观察快照,包括智能体的位置、持有的物品、环境中可使用的工具等信息,还包括违反规则时会被触发的反馈。

记忆组件记录了每个时间步骤的环境状态和智能体状态。

利用这些组件,大模型会先输出对任务规划的文本描述,接下来还有两个关键步骤:

动作提取,用正则表达式提取输出文本中的动作,这一步是必不可少的,因为输出文本黄总可能包含大模型思维过程,甚至是察觉到失误而道歉的信息。

动作验证,评估每个动作的可行性,如果发现无法执行则返回错误消息。

最终,团队在实验中得到如下发现:

gpt-4在零样本条件下就能根据简单的游戏说明调度2-4个智能体完成菜肴制作,甚至可以与人类玩家协作。 提供极少量的专家演示,解释某些动作的推理、以及在规划过程中提供实时反馈,可以显著提升大模型的多智能体规划表现。 可以从更少智能体的例子推广到协调更多智能体,以及适应新的游戏领域。 与经典的专用规划算法相比,大模型规划仍存在计算成本、上下文长度限制、非最优规划等瓶颈,但可以从数据中在线改进,更灵活地适应不同规划问题。 在人机互动实验中,不同数量智能体与人协作会提高任务成功率,但太多智能体也会降低游戏乐趣。

另外,论文附录上还给出了系统提示词示例,如果想让ai学会玩你喜欢的游戏,可以参考一下。

论文地址:

https://www.microsoft.com/en-us/research/publication/mindagent-emergent-gaming-interaction/